这篇文章主要讲解了“Python中Sync与Async执行速度快慢实例对比分析”,文中的讲解内容简单清晰,易于学习与理解,下面请大家跟着小编的思路慢慢深入,一起来研究和学习“Python中Sync与Async执行速度快慢实例对比分析”吧!

1.一个简单的例子

首先先从一个例子了解两种调用方法的差别, 为了能清晰的看出他们的运行时长差别, 都让他们重复运行10000次, 具体代码如下:

import asyncio

import time

n_call = 10000

# sync的调用时长

def demo(n: int) -> int:

return n ** n

s_time = time.time()

for i in range(n_call):

demo(i)

print(time.time() - s_time)

# async的调用时长

async def sub_demo(n: int) -> int:

return n ** n

async def async_main() -> None:

for i in range(n_call):

await sub_demo(i)

loop = asyncio.get_event_loop()

s_time = time.time()

loop.run_until_complete(async_main())

print(time.time() - s_time)

# 输出

# 5.310615682601929

# 5.614157438278198可以看得出来,

syncasyncasync defasync defawaitasync_mainsyncasync造成这样的原因是同样由同一个线程执行的情况下(cpu单核心),

asyncsyncasyncasyncsyncNOTE: 目前所说的

async2.一个io的例子

为了了解

async

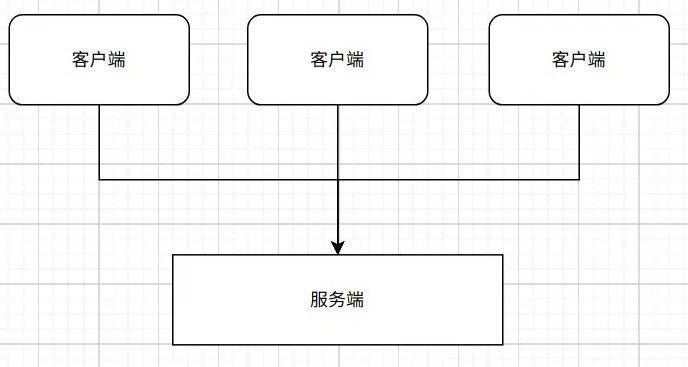

在这种场景下, 客户端请求都是在短时间内发出的。 而服务端为了能够在短时间内处理大量的请求, 防止处理延迟, 都会以某种方式来支持并发或者并行。

NOTE: 并发,在操作系统中,是指一个时间段中有几个程序都处于已启动运行到运行完毕之间,且这几个程序都是在同一个处理机上运行,但任一个时刻点上只有一个程序在处理机上运行。 并行是计算机系统中能同时执行两个或多个处理的一种计算方法。

对于

syncNOTE: 进程是最小的资源分配单位, 过多的进程会占用很多系统资源, 一般的后台服务启用的进程数量不会很多, 同时线程是最小的调度单位, 所以以下的调度我都以线程来描述。

但是这种方式是很耗系统的资源的(相对于协程来说), 因为线程的运行都是靠cpu来执行的, 而cpu是有限的, 同一时刻只能支持固定的几个worker运行, 其他线程则得等待被调度, 这样就意味着每个线程都只能工作一个时间分片, 之后就会被调度系统控制进入阻塞或者就绪阶段, 让位给其他线程, 直到下次获取时间分片时才可以继续运行。 为了能模拟出同一时刻内, 多个线程同时运行, 且防止其他线程饿死的情况, 线程每次获得的运行时间很短, 线程间的调度切换很频繁, 当启用更多的进程和更多的线程时, 调度就会更加的频繁。

不过调度线程的开销还不算大, 比较大的开销是调度线程而产生的下文切换和竞争条件(具体可以参考《计算机导论》中进程调度相关的资料, 我这里只是简单说明), cpu在执行代码时,它需要把数据加载到cpu的缓存中去的再运行, 当cpu运行的线程在这个时间分片内执行完成时, 该线程的最新运行数据就会保存起来, 然后cpu会去加载准备被调度的线程的数据, 并运行。 虽然这部分暂存数据是保存在比内存更快, 比内存更靠近cpu的寄存器上, 但是寄存器的访问速度也没有cpu缓存的访问速度快, 所以cpu在切换运行的线程时, 都会花上一部分时间用来装载数据上还有装载缓存时的竞争问题。

对比线程的调度产生的上下文切换与抢占式,

async这种切换协程的方式称为协作式多任务处理, 由于只会在单个进程或者单个线程中运行, 切换协程时上下文是不用改变的, cpu不用重新读写缓存, 所以会节省一些开销。 从上面可以看出协作式切换执行权是基于协程自己主动让出的, 而线程是抢占式的, 线程在没遇到io事件时, 也可能从运行状态转为就绪状态, 直到再次被调用, 这样会多出很多调度带来的开销, 而协程是会一直运行, 直到遇到让步事件才切换, 所以协程调度的次数会比线程少很多。 同时可以看出协程的何时调度是由开发者指定(比如上面所说的等等数据库返回事件), 而且是非抢占式的, 这就意味着某个协程在运行时, 其他协程是没办法运行的, 只能等到运行的协程交出执行权, 所以开发者要确保不能让任务在cpu上停留太长时间,否则剩余的任务就会饿死。